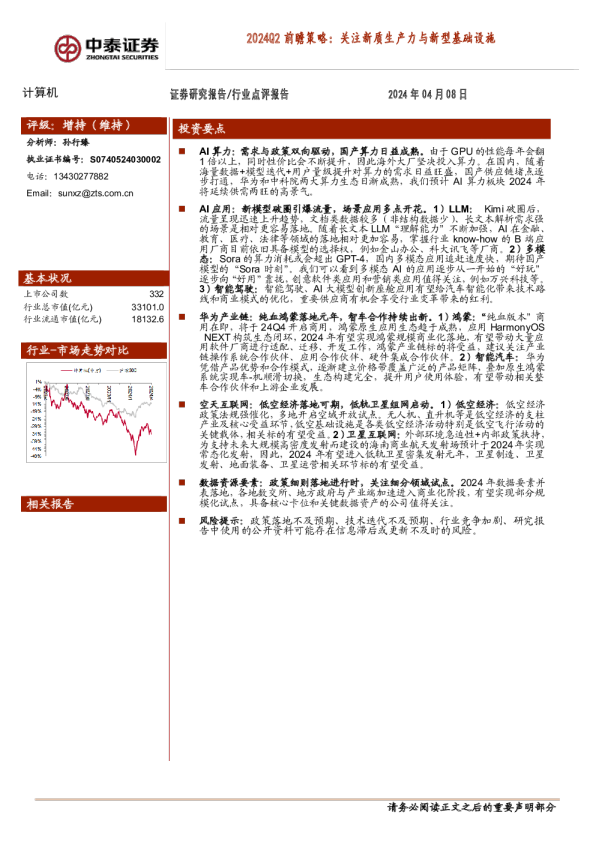

计算机2024Q2前瞻策略:关注新质生产力与新型基础设施

AI智能总结

AI智能总结

AI算力:需求与政策双向驱动,国产算力日益成熟。由于GPU的性能每年会翻1倍以上,同时性价比会不断提升,因此海外大厂坚决投入算力。在国内,随着海量数据+模型迭代+用户量级提升对算力的需求日益旺盛,国产供应链堵点逐步打通,华为和中科院两大算力生态日渐成熟,我们预计AI算力板块2024年将延续供需两旺的高景气。 AI应用:新模型破圈引爆流量,场景应用多点开花。1)LLM:Kimi破圈后,流量呈现迅速上升趋势,文档类数据较多(非结构数据少)、长文本解析需求强的场景是相对更容易落地。随着长文本LLM“理解能力”不断加强,AI在金融、教育、医疗、法律等领域的落地相对更加容易,掌握行业know-how的B端应用厂商目前依旧具备模型的选择权,例如金山办公、科大讯飞等厂商。2)多模态:Sora的算力消耗或会超出GPT-4,国内多模态应用追赶速度快,期待国产模型的“Sora时刻”。我们可以看到多模态AI的应用逐步从一开始的“好玩”逐步向“好用”靠拢,创意软件类应用和营销类应用值得关注,例如万兴科技等。 3)智能驾驶:智能驾驶、AI大模型创新座舱应用有望给汽车智能化带来技术路线和商业模式的优化,重要供应商有机会享受行业变革带来的红利。 华为产业链:纯血鸿蒙落地元年,智车合作持续出新。1)鸿蒙:“纯血版本”商用在即,将于24Q4开启商用,鸿蒙原生应用生态趋于成熟,应用HarmonyOS NEXT构筑生态闭环,2024年有望实现鸿蒙规模商业化落地,有望带动大量应用软件厂商进行适配、迁移、开发工作,鸿蒙产业链标的将受益,建议关注产业链操作系统合作伙伴、应用合作伙伴、硬件集成合作伙伴。2)智能汽车:华为凭借产品优势和合作模式,逐渐建立价格带覆盖广泛的产品矩阵,叠加原生鸿蒙系统实现车-机顺滑切换,生态构建完全,提升用户使用体验,有望带动相关整车合作伙伴和上游企业发展。 空天互联网:低空经济落地可期,低轨卫星组网启动。1)低空经济:低空经济政策法规强催化,多地开启空域开放试点。无人机、直升机等是低空经济的支柱产业及核心受益环节,低空基础设施是各类低空经济活动特别是低空飞行活动的关键载体,相关标的有望受益。2)卫星互联网:外部环境急迫性+内部政策扶持,为支持未来大规模高密度发射而建设的海南商业航天发射场预计于2024年实现常态化发射,因此,2024年有望进入低轨卫星密集发射元年,卫星制造、卫星发射、地面装备、卫星运营相关环节标的有望受益。 数据资源要素:政策细则落地进行时,关注细分领域试点。2024年数据要素并表落地,各地数交所、地方政府与产业端加速进入商业化阶段,有望实现部分规模化试点,具备核心卡位和关键数据资产的公司值得关注。 风险提示:政策落地不及预期、技术迭代不及预期、行业竞争加剧、研究报告中使用的公开资料可能存在信息滞后或更新不及时的风险。 请务必阅读正文之后的重要声明部分 1.AI:算力与应用齐头并进,国产生态加速崛起 1.1 AI算力:需求与政策双向驱动,国产算力日益成熟 需求拉动:生成式AI催生算力需求,海量数据+模型迭代+用户量级提升下算力扩容需求明确。生成式AI的浪潮兴起,海内外大模型百花齐放,在训练端,大模型训练所需算力每3-4个月增长1倍,增速远超18-24个月增长1倍的摩尔定律;在推理端,各大厂商推出的模型数量和参数量增长,叠加用户使用频率提升和模型渗透进千行百业,模型的推理算力需求持续增长。据灼识咨询,预计2030年全球算力规模达到56ZFlops,智能算力2021-2030年年均复合增长率将超65%;据前瞻产业研究院测算,预计2022-2024年中国人工智能芯片市场规模复合增长率达46.05%。 图表1:2021-2030E全球计算设备算力总规模(单位:Eflops) 图表2:2019-2024E中国人工智能芯片市场规模 政策驱动:政策层推动基础算力建设,AI算力部署乘东风。我国对智算产业发展重视程度较高,围绕智算中心、人工智能、大模型陆续出台相关政策,2022年2月,国家布局八大国家枢纽节点和10大数据中心集群,协调区域平衡化发展。根据《中国算力发展指数白皮书(2023年)》,截至2023年6月,全国已投运、在建的智算中心分别达25个、20+个;广东、四川、重庆、浙江、上海、成都、北京陆续发布关于促进智算中心建设的相关政策。 图表:算力建设相关政策梳理发布日期发布部门 国产芯片崛起:华为和中科院两大算力生态日渐成熟。在海外高性能算力芯片供应受限的背景下,国产算力芯片奋起直追,性能表现优异、生态逐渐搭建完善,连续斩获订单,获得客户认可。 2024年3月22日,上海市通信管理局等11个部门联合印发《上海市智能算力基础设施高质量发展“算力浦江”智算行动实施方案(2024-2025年)》表示,2025年上海市市新建智算中心国产算力芯片使用占比超50%。 华为生态:华为昇腾芯片是华为公司发布的两款人工智能处理器,包括 昇腾910和昇腾310处理器,在硬件性能领先,软件对标CUDA,成 为智算中心建设主导力量的重要角色。1)据中国基金报消息,2023年 11月百度为200台服务器订购了1600片昇腾910B AI芯片,截至 2023年10月华为已向百度交付了超过60%的订单。2)据科大讯飞, 华为昇腾910B能力已经基本做到对标英伟达A100的能力。 中科院生态:海光信息的GPGPU产品计算性能强大、能效比较高,在双精度、单精度、半精度、整型计算方面表现均较为优异,并能兼容“类CUDA”环境。1)深算一号产品性能达到国际上同类型高端产品的水平;2)2023年三季度发布的深算二号,实现了在大数据、人工智能、商业计算等领域的商用,该产品具有全精度浮点数据和各种常见整型数据计算能力,性能相对于深算一号性能提升100%以上。 图表:海光与海外项目 海外大厂坚决投入算力。根据The Information报道,微软和OpenAI正计划建设一个名为星际之门(Stargate)的特殊数据中心,微软高层计划最快在2028年启动该项目,会配备数百万专用的服务器芯片,项目的成本预计高达1150亿美元。OpenAI将在明年初发布下一次重大升级。从微软大幅的Capex投入可以看出,大厂对于AI的投入目前依旧十分坚决。 图表5:微软与OpenAI计划投资千亿建设数据中心 根据“黄氏定律”,GPU的性能每年会翻1倍以上,同时性价比会不断提升。 黄仁勋在GTC答记者问曾提到,B200的售价在3~4万美金,而性能则是H100的5倍。 图表6:单芯片推理性能在过去10年提升了1000倍 随着海量数据+模型迭代+用户量级提升对算力的需求日益旺盛,以及国产供应链堵点逐步打通,我们预计AI算力板块2024年将延续供需两旺的高景气。建议关注:海光信息、中科曙光、奥普光电、神州数码、烽火通信。 1.2 AI应用:新模型破圈引爆流量,场景应用多点开花 1)LLM 国产大模型新玩家持续入局,应用层落地有望加速。Kimi是月之暗面(Moonshot AI)于2023年10月推出的一款智能助手,主要应用场景为专业学术论文的翻译和理解、辅助分析法律问题、快速理解API开发文档等,是全球首个支持输入20万汉字的智能助手产品,目前已启动200万字无损上下文内测。从模型对比层面上,第三方测评显示kimi整体能力在国内前三,kimi的上下文长度领先国内外所有模型,最新版本支持200万汉字上下文,且能够直接超多文件上传。另一方面,kimi在工程化能力方面有表现优异,推理成本显著低于同行,相比通义32k上下文千亿模型的API,公司支持128k上下文的API定价仅为其一半。 Kimi破圈后,流量呈现迅速上升趋势,目前kimi的网页访问量已经超越文心一言,成为国产访问量最高的AI模型。Kimi的破圈效应带动其他大模型厂商迅速更近,通义千问和文心一言也陆续开放超长上下文版本,其中通义千问目前已经支持1000万汉字上下文输入,后续预计更多模型会把长文本作为标配。 图表7:Kimi支持200万上下文 图表8:通义推出长上下文功能,能够进行多文档分析 图表9:国产大模型流量数据(最新到2024/3/25,单位:百万次) 文档类数据较多(非结构数据少)、长文本解析需求强的场景是相对更容易落地。参考kimi官方给出case,200万上下文比较好的应用场景包括英伟达财报、德州扑克教程和诊疗手册,可以看出长文本AI在金融、教育和医疗领域的落地相对更加容易,这些场景的共性是涉及到长文本的环节比较多,并且相对而言结构化数据比较少,对于向量数据库的需求度相对偏低。 图表10:Kimi能够教用户打牌 图表11:Kimi提供诊疗建议 请务必阅读正文之后的重要声明部分-7- 图表12:教育类应用流量数据(最新到2024/3/25,单位:百万次) 除此之外,法律也是一个值得关注的方向。目前在美国一级市场,AI+法律是一个非常热门的话题。根据Thomson Reuters的研究,接近一半的Big Law在高层制定了AI转型策略,58%的法律专业人士对于AI提高生产力表示乐观;38%的人认为AI可以为更高级别的任务腾出时间。 LLM能力的提升,使得法律AI在合同管理、诉讼预测、法律研究等80%的工作中效果会更好。法律研究为例,NLP主要依赖搜索关键词和初步分析为主,比如确定某句话对应的具体法律条款,但是LLM可以启用对话式的搜索方式,可以对研究内容进行总结提炼,回答细节问题。LLM的生成能力使得AI能够在法律领域执行更复杂的任务,从“提取”到“生成”,如自动起草法律合同和为法官提供判决建议。 图表13:超过一半的法律专业调查者对AI乐观 图表14:法律技术、AI、自动化被法律部门视为最有效的创新解决方案 具备平台型能力的应用公司受益于长上下文。我们认为不同于C端可能出现的AI Native应用,B端应用厂商掌握更加完整的解决方案(行业knowhow),模型更多的作为底座和赋能存在,很难完全替代应用厂商的存在。例如金山办公同时接入了minimax、文心一言、智谱、通义千问和讯飞星火,微软同时投资了OpenAI和Mistral,都体现出平台化的B端应用厂商目前依旧具备 请务必阅读正文之后的重要声明部分-8- 模型的选择权。 类似于kimi的超长上下文模型实际上提供的是单点能力上的突破,在超长上下文领域做出了特色。对于具备平台化解决方案的应用厂商而言,kimi提供的是长文本领域能力的补全,提升的是平台化应用厂商解决方案的延展性,这一类厂商也是我们关注且推荐的。 2)多模态 Sora的出现为文生视频在应用端落地带来了曙光。2月16日,OpenAI发布了首个文生视频模型Sora。Sora可以直接输出长达60秒的视频,并且包含高度细致的背景、复杂的多角度镜头,以及富有情感的多个角色。相比以往的文生视频模型,Sora最大的颠覆性在于能够更大程度的还原真实物理世界,并且将文生视频的长度从4s拉长到1min。从Sora近期的进展,我们可以看到多模态AI的应用逐步从一开始的“好玩”逐步向“好用”靠拢。 3月25日,Sora在blog上放出了由7个艺术家生成的作品,这些作品是获得Sora访问权限的电影制作人、艺术家、广告公司和音乐家制作完成的:“气球人”短片:shy kids是一家多媒体制作公司,他们利用Sora制作了一部关于气球人的励志短片Air Head。导演Walter Woodman认为Sora最惊艳的是能够创造完全超现实事物,认为这是抽象表现主义的新时代。 Paul Trillo:Paul Trillo是一位艺术家、作家和导演,他的作品赢得了《滚石》和《纽约客》等媒体的高度赞誉。Paul Trillo生成的短片采用了快镜头的方式,以金属人的视角探索世界。Paul提到与Sora合作让他不再受时间、资金或他人许可的限制,我能够自由地探索和尝试,以大胆和创新的方式进行创作。 Nik Kleverov:Native Foreign是一家