证券研究报告行业深度:边缘计算--始于AI,赋能应用

AI智能总结

AI智能总结

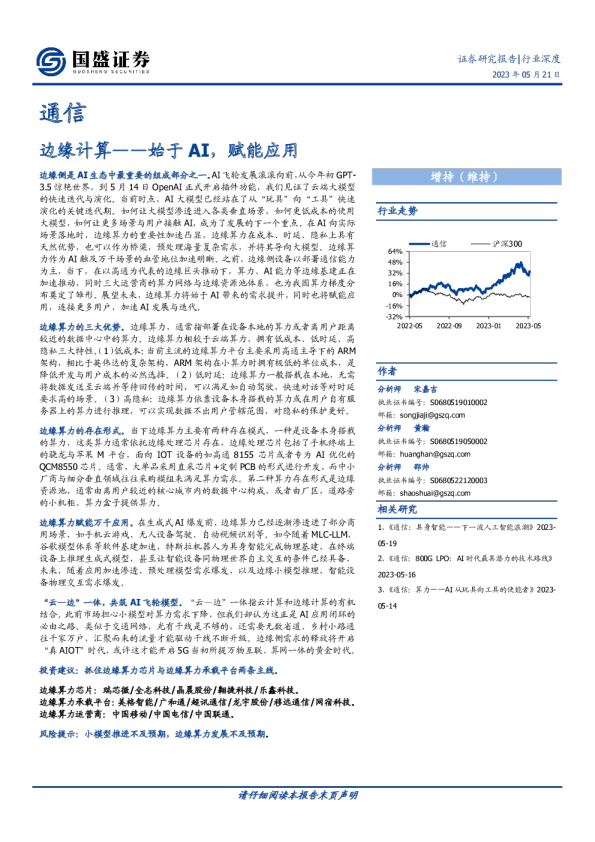

边缘侧是AI生态中最重要的组成部分之一。AI飞轮发展滚滚向前,从今年初GPT-3.5惊艳世界,到5月14日OpenAI正式开启插件功能,我们见证了云端大模型的快速迭代与演化。当前时点,AI大模型已经站在了从“玩具”向“工具”快速演化的关键迭代期。如何让大模型渗透进入各类垂直场景,如何更低成本的使用大模型,如何让更多场景与用户接触AI,成为了发展的下一个重点。在AI向实际场景落地时,边缘算力的重要性加速凸显,边缘算力在成本、时延、隐私上具有天然优势,也可以作为桥梁,预处理海量复杂需求,并将其导向大模型。边缘算力作为AI触及万千场景的血管地位加速明晰。之前,边缘侧设备以部署通信能力为主,当下,在以高通为代表的边缘巨头推动下,算力、AI能力等边缘基建正在加速推动,同时三大运营商的算力网络与边缘资源池体系,也为我国算力梯度分布奠定了雏形。展望未来,边缘算力将始于AI带来的需求提升,同时也将赋能应用,连接更多用户,加速AI发展与迭代。 边缘算力的三大优势。边缘算力,通常指部署在设备本地的算力或者离用户距离较近的数据中心中的算力。边缘算力相较于云端算力,拥有低成本、低时延、高隐私三大特性。(1)低成本:当前主流的边缘算力平台主要采用高通主导下的ARM架构,相比于英伟达的复杂架构,ARM架构在小算力时拥有极低的单位成本,是降低开发与用户成本的必然选择。(2)低时延:边缘算力一般搭载在本地,无需将数据发送至云端并等待回传的时间,可以满足如自动驾驶,快速对话等对时延要求高的场景。(3)高隐私:边缘算力依靠设备本身搭载的算力或在用户自有服务器上的算力进行推理,可以实现数据不出用户管辖范围,对隐私的保护更好。 边缘算力的存在形式。当下边缘算力主要有两种存在模式,一种是设备本身搭载的算力,这类算力通常依托边缘处理芯片存在,边缘处理芯片包括了手机终端上的骁龙与苹果M平台,面向IOT设备的如高通8155芯片或者专为AI优化的QCM8550芯片。通常,大单品采用直采芯片+定制PCB的形式进行开发,而中小厂商与细分垂直领域往往采购模组来满足算力需求。第二种算力存在形式是边缘资源池,通常由离用户较近的核心城市内的数据中心构成,或者由厂区,道路旁的小机柜、算力盒子提供算力。 边缘算力赋能万千应用。在生成式AI爆发前,边缘算力已经逐渐渗透进了部分商用场景,如手机云游戏、无人设备驾驶、自动视频识别等。如今随着MLC-LLM,谷歌模型体系等软件基建加速,特斯拉机器人为具身智能完成物理基建,在终端设备上推理生成式模型,甚至让智能设备同物理世界自主交互的条件已经具备,未来,随着应用加速渗透、预处理模型需求爆发,以及边缘小模型推理,智能设备物理交互需求爆发。 “云—边”一体,共筑AI飞轮模型。“云—边”一体指云计算和边缘计算的有机结合。此前市场担心小模型对算力需求下降,但我们却认为这正是AI应用闭环的必由之路。类似于交通网络,光有干线是不够的,还需要无数省道、乡村小路通往千家万户,汇聚而来的流量才能驱动干线不断升级。边缘侧需求的释放将开启“真AIOT”时代,或许这才能开启5G当初所提万物互联、算网一体的黄金时代。 投资建议:抓住边缘算力芯片与边缘算力承载平台两条主线。 边缘算力芯片:瑞芯微/全志科技/晶晨股份/翱捷科技/乐鑫科技。 边缘算力承载平台:美格智能/广和通/超讯通信/龙宇股份/移远通信/网宿科技。 边缘算力运营商:中国移动/中国电信/中国联通。 风险提示:小模型推进不及预期,边缘算力发展不及预期。 1.投资要件 当前市场普遍聚焦于云端算力发展,忽视了边缘算力在AI乃至社会数字化发展中的重要地位。随着AI大模型应用逐渐渗透进入千行百业和各类垂直细分场景,单纯的大规模计算中心提供的算力将不能满足多样化的AI运算需求。基于几点判断,我们认为边缘算力具备不可或缺性: 第一,未来随着计算芯片加速发展,单位算力成本中,电费与土地费用占比将愈发提升,算力成本将取决于智算中心的地理位置,以我国举例,未来算力成本较低的西部将是云端算力主要部署地。因此,大算力与低时延需求将出现错配。 第二,AI模型推理Token费用较贵,如果需要成熟商用,边缘预处理将是必须选项。通过边缘部署的算力,将用户的多样化需求进行本地的预处理,简单的需求直接利用本地模型和算力推理,复杂需求通过边缘算力预处理后,精简成最少的TOKEN发送至云端,从而能够最低成本的实现应用功能,加速商业化。同时,面向小算力时,ARM架构由于其架构简单,比英伟达复杂架构计算卡更具成本优势,也将加速边缘小算力的渗透速度。 最后,无论是对用户个人敏感数据进行推理,还是推理设计商业敏感数据,完全与云端隔绝的边缘算力,能为用户提供最好的数据安全保护。因此,从时延、成本、隐私三大方面来看,边缘算力未来算力体系的重要构成部分,也是AI需求连接万物的毛细血管。 当前市场普遍聚焦于边缘场景中的大单品逻辑,忽视了边缘生态的多样性。当前市场聚焦于智能音响,智能耳机等大单品及其部件,主要是其作为AI入口的逻辑更具备直接性。但我们认为,随着AI加速向边缘渗透,应用的形式将愈发多样,越来越多的中小厂商将参与到不同场景,不同细分领域的AI智能硬件开发中来。随着应用形式愈发多样,如何在海量不同设备上部署标准化的AI边缘算力将成为一个重要问题。我们判断,物联网模组将成为承载这类算力的重要形式。物联网模组集成了通信芯片与全球大厂的算力芯片,能为海量场景和中小厂商提供稳定的边缘通信能力和边缘算力,大大降低了中小开发者部署边缘算力的门槛和难度。AI时代,是万众创新的年代,海量的开发将来自中小开发者,而模组提供的算力,将成为边缘算力中的重要部分。 行业催化因素: 1.边缘小模型以及解决方案加速推进,模型蒸馏加速简化。 2.搭载边缘模型与边缘算力的智能设备快速放量。 投资建议: 抓住边缘算力芯片与边缘算力承载平台两条主线。 边缘算力芯片:高通/瑞芯微/全志科技/晶晨股份/翱捷科技。 边缘算力承载平台:美格智能/广和通/龙宇股份/网宿科技。 边缘算力运营商:中国移动/中国电信/中国联通。 风险提示: 1.小模型推进不及预期。 2.边缘计算不及预期。 2.模型由大到小,AI走上应用的快速路 今年年初,随着Chatgpt的发布,以LLM模型为主导的生成式大模型高速发展。在Chatgpt之前,AI发展通常以面向细分行业的小模型为主,追求较小运行成本下的较快商业化。 Chatgpt问世之后,证明了“野蛮”堆砌参数与算力的生成式模型之路是可以走通的,因此,短期内全球AI模型开发的风向转向了堆砌参数与算力的模式。 随着GPT-4的发布,标志大语言模型正式迈入了多模态时代,参数量近一步膨胀。4月份,OPENAI创始人SAMAltman在一场MIT举办的活动上表示,“未来的AI进展不会来自于让模型变得更大”,我们认为,这代表着OPENAI之后的努力将会更多的转向如何让现有的大模型更好用,渗透进更多的场景。 从北美的趋势来看,当下,在大模型基础上,快速建立小模型生态,正是许多大模型龙头正在高速推进的发展方向。如何推动模型实现“人人可训,人人可用”已经成了海外大厂争相布局的方向。 4月12日,微软正式开源DeepSpeedchat训练模型,这个训练方式拥有三大核心优势,第一,简化ChatGPT类型模型的训练和强化推理体验,第二,DeepSpeed-RLHF模块,第三,DeepSpeed-RLHF系统。 基于这三大特性,DeepSpeed-HE比现有系统快15倍以上,使RLHF训练快速且经济实惠。例如,DeepSpeed-HE在Azure云上只需9小时即可训练一个OPT-13B模型,只需18小时即可训练一个OPT-30B模型。这两种训练分别花费不到300美元和600美元。 此外,该系统可以支持超千亿参数的模型训练,并且增强了对于单张显卡的训练支持,仅凭单个GPU,DeepSpeed-HE就能支持训练超过130亿参数的模型。 图表1:DeepSpeed训练花费 如果说DeepSpeedchat是模型界迈向应用与生态建设的第一步,那么在五月初的几大变化,让我们更加坚信了,万物搭载模型,模型赋能万物的时代正在加速到来。 首先,便是知名华人AI研究者陈天奇牵头开发的MLC-LLM解决方案,MLC LLM为用户在各类硬件上原生部署任意大型语言模型提供了解决方案,可将大模型应用于移动端(例如iPhone)、消费级电脑端(例如Mac)和Web浏览器。 MLC的主要功能包括了: (1)支持不同型号的CPU、GPU以及其他可能的协处理器和加速器。 (2)部署在用户设备的本地环境中,这些环境可能没有python或其他可用的必要依赖项;通过仔细规划分配和积极压缩模型参数来解决内存限制。 (3)MLC LLM提供可重复、系统化和可定制的工作流,使开发人员和AI系统研究人员能够以Python优先的方法实现模型并进行优化。MLC LLM可以让研究人员们快速试验新模型、新想法和新的编译器pass,并进行本地部署。 图表2:MLC项目概览 其次,我们看到了随着Meta开源LLaMA,整个北美AI开发者中,正在快速兴起基于LLaMA的训练风潮,同时随着Lora等训练方法的加速渗透,我们判断,中小开发者蒸馏,训练,部署自由模型的成本正在快速降低,整个开源生态下,模型梯度分布的格局正在加速建立。 Lora训练法通过冻结预训练的模型权重 , 并将可训练的秩分解成矩阵注入到Transformaer架构的每一层,极大的减少了下游任务的可训练参数的数量,有效提升了预训练模型在下游任务的finetune效率。 图表3:Lora模型 上述的三种模型或解决方案,DeepspeedChat,MLC-LLM,Lora模型,其中Deepspeed与Lora模型给中小开发者提供了低成本,快速训练专属于自己的小模型的完整工具,而MLC-LLM则为中小开发者在算力较低的环境或者边缘进行模型的推理搭建了基础,三大工具,我们认为已经形成了AI走向边缘的“基建雏形”。 上文阐述了来自开源社区或者中小开发者参与的模型应用变化,在Chatgpt面世以来,大厂也在加速边缘推理能力,小模型的开发。 2月,全球手机与IOT芯片龙头高通,展示了其在搭载8Gen2的手机平台生利用StableDiffusion生成了图片,耗时小于15秒。在5月,高通通过持续优化,将生成图片的时间缩短至12秒。 图表4:高通在手机上运行StableDiffusion 高通通过与其芯片配套的全栈AI优化方案,将stablediffusion模型从FP32压缩至INT8,显著的降低了运行时延和能耗,从而实现了模型在手机算力上的安全高效推理。高通发布的全栈AI工具,包括了INT8转化,最小化内存溢出,适配Hexagon处理器的AI加速等功能,能够让OEM厂商快速在高通的算力环境中部署其AI应用。 图表5:高通全栈AI优化 在5月,谷歌也发布了其全新的语言大模型PaLM2,并作为发布会中大部分AI功能的基础模型,值得注意的是,PaLM2是一个拥有众多版本和参数量的模型体系,其包含了4个不同参数的模型,包括壁虎(Gecko)、水獭(Otter)、野牛(Bison)和独角兽(Unicorn),并在特定领域的数据上进行了微调,为企业客户执行某些任务。其中PaLM 2的最轻版本Gecko足够小,可以在手机上运行,每秒处理20个tokens,大约相当于16或17个英文单词,谷歌在模型梯度分布上的重视程度,也进一步验证了小模型作为AI渗透进入万千场景的必要性。 图表6:谷歌基于PaLM2的模型体系 将视角拉回国内,国内厂商在边缘小模型上也正在加速布局,5月,中科创达发布Rubik魔方大模型,根据公司官网介绍,中科创达基于在机器人领域的深厚积累,中科创达将智能音箱与机器人进行融合,并通过中科创达魔方Rubik大模型的不断训练,已经实现了能够自由对话的智能销售机器人,可以自主回答客户关于企业及产品