【中文译版】StableDiffusion3技术报告

AI智能总结

AI智能总结

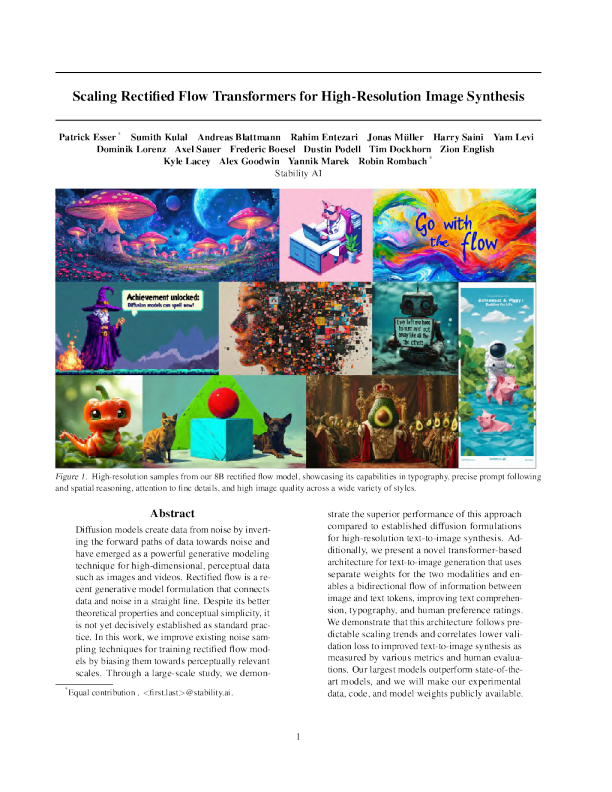

**凯尔·莱西亚历克斯·古德温扬尼克·马雷克罗宾·隆巴赫稳定性人工智能苏米斯·库拉尔安德烈亚斯·布拉特曼拉希姆·恩特扎里乔纳斯·穆勒哈里·赛尼亚姆·莱维多米尼克·洛伦茨阿克塞尔·绍尔弗雷德里克·博塞尔达斯汀·波德尔蒂姆·多克霍恩锡安英语¡帕特里克·埃塞尔 抽象的 阐述该方法的优越性能两种模式的权重分开,并实现信息之间的双向流动用于高分辨率文本到图像的合成。此外,我们提出了一种新颖的基于变压器的与已建立的扩散配方相比用于文本到图像生成的架构,使用 高维感知数据技术扩散模型通过将数据的前向路径反转为噪声来创建数据。尚未被明确确立为标准实践。在这项工作中,我们改进了现有的噪声采样技术,通过将修正流模型偏向于感知相关的模型来训练它们例如图像和视频。整流流是一种最新的生成模型公式,它将已经成为一种强大的生成模型数据和噪声成一条直线。尽管它更好理论特性和概念简单性,它 图像和文本标记,提高文本理解、排版和人类偏好评级。通过各种指标和人类评估来衡量。我们最大的模型优于最先进的模型,我们将进行实验我们证明该架构遵循可预测的缩放趋势,并将较低的验证损失与改进的文本到图像合成相关联,如下所示 秤。通过大规模研究,我们证明�� 数据、代码和模型权重公开。 缩放整流流量变压器以实现高分辨率图像合成 一、简介 到模型中(例如,通过交叉注意力(Vaswani等人,2017;Rombach等人,2022))并不理想,并且提出了一种新的架构,该架构结合了图像和文本标记的可学习流,这使得它们之间的双向信息流。我们将其与我们的 它们被训练将数据的前向路径反转为随机噪声,因此,结合神经网络的近似和泛化特性,可以用来生成训练数据中不存在但遵循训练分布的新数据点数据(Sohl‑Dickstein等人,2015年;Song和Ermon,2020年)。 改进了整流流公式并研究了其可扩展性。我们展示了验证损失的可预测缩放趋势,并表明较低的验证损失与改进的自动和人工评估密切相关。 这种生成建模技术已被证明对于对图像等高维感知数据进行建模非常有效(Hoetal.,2020)。近年来,扩散模型已成为从自然语言输入生成高分辨率图像和视频的事实上的方法,具有令人印象深刻的泛化能力(Saharia等人,2022b;Ramesh等人,2022;Rombach等人,2022 ) ;Podell等人,2023;Dai等人,2023;Esser等人,2023;Blattmann等人,2023b;Betker等人,2023;Blattmann等人,2023a;Singer等人,2022) 。由于其迭代性质和相关的计算成本,以及推理过程中的较长采样时间,对这些模型进行更有效训练和/或更快速采样的公式的研究有所增加(Karras等人,2023年;Liu等人,2023年)。 ,2022)。 我们最大的模型优于最先进的开放模型,例如SDXL(Podell等人,2023)、SDXL‑Turbo(Sauer等人,2023)、Pixart‑α(Chen等人,2023)和封闭模型‑源模型,例如DALL‑E3(Betkeretal.,2023) ,均用于即时理解和人类偏好评级的定量评估(Ghoshetal.,2023) 。 我们工作的核心贡献是:(i)我们对不同的扩散模型和整流流公式进行了大规模、系统的研究,以确定最佳设置。 为此,我们为整流流模型引入了新的噪声采样器,与之前已知的采样器相比,其性能得到了提高。(ii)我们设计了一种新颖的、可扩展的文本到图像合成架构,允许网络内文本和图像令牌流之间的双向混合。我们展示了它与UViT(Hoogeboometal.,2023)和DiT(Peebles&Xie,2023)等已建立的骨干网相比的优势。最后,我们(iii)对我们的模型进行缩放研究,并证明它遵循可预测的缩放趋势。我们表明,较低的验证损失与通过T2I‑CompBench(Huang等人,2023)、GenEval(Ghosh等人,2023)和人类评分等指标评估的文本到图像性能的提高密切相关。我们公开结果、代码和模型权重。 虽然指定从数据到噪声的前向路径可以实现高效的训练,但它也提出了选择哪条路径的问题。这种选择可能对采样产生重要影响。例如,无法消除数据中所有噪声的前向过程可能会导致训练和测试分布的差异,并导致诸如灰度图像样本之类的伪影(Lin等人,2024)。重要的是,前向过程的选择也会影响学习到的后向过程,从而影响采样效率。虽然弯曲路径需要许多积分步骤来模拟该过程,但直线路径可以用单个步骤进行模拟,并且不易出现误差累积。由于每个步骤都对应于神经网络的评估,因此这对采样速度有直接影响。 2.流程的无模拟训练 我们考虑使用常微分方程(ODE)定义噪声分布p1的样本x1到数据分布p0的样本x0之间的映射的生成模型, 前向路径的一个特殊选择是所谓的整流流(Liuetal.,2022;Albergo&Vanden‑Eijnden,2022;Lipmanetal.,2023),它将数据和噪声连接在一条直线上。尽管该模型类具有更好的理论特性,但尚未在实践中得到决定性的确立。到目前为止,一些优势已经在中小型实验中得到了实证证明( Maetal.,2024),但这些大多局限于类条件模型。在这项工作中,我们通过在修正流模型中引入噪声尺度的重新加权来改变这一点,类似于噪声预测扩散模型(Hoetal.,2020)。通过大规模研究,我们将新配方与现有扩散配方进行比较并证明其优点。 其中速度v由神经网络的权重θ参数化。Chen等人之前的工作。(2018)建议通过可微ODE求解器直接求解方程(1) 。然而,这个过程的计算成本很高,特别是对于参数化vθ(yt,t)的大型网络架构。更有效的替代方法是直接回归向量场ut ,生成p0和p1之间的概率路径。为了构建这样的ut,我们定义一个前向过程,对应于p0和p1=N(0,1)之间的概率路径pt ,如下 缩放整流流量变压器以实现高分辨率图像合成 人们可以推导出各种加权损失函数,这些函数为所需的解决方案提供信号,但可能会影响优化轨迹。为了对不同方法(包括经典的扩散公式)进行统一分析,我们可以将目标写成以下形式(遵循Kingma&Gao(2023)): 对于a0=1、b0=0、a1=0和b1=1,边际, 与数据和噪声分布一致。 ,我们介绍‑ 将zt、x0与duceψt和ut之间的关系表示为 t=ut(zt|),由于zt可以写为初始值z0=x0的ODEz的解,因此ut(·|)生成pt(·|)。值得注意的是,我们可以使用条件向量场ut(·|)构造一个边缘向量场ut ,它生成边缘概率路径pt( Lipmanetal.,2023)(参见B.1) : 3.流动轨迹 在这项工作中,我们考虑了上述形式主义的不同变体,我们将在下面简要描述。 整流流整流流(RFs)(Liuetal.,2022;Albergo&Vanden‑Eijnden,2022;Lipmanetal.,2023)将前向过程定义为数据分布和标准正态分布之间的直线路径,即 使用流量匹配目标回归ut时 由于方程6中的边缘化,条件流匹配(参见B.1),直接处理是很棘手的, 并使用LCFM ,然后对应于w网络输出直接参数化速度vθ。 EDMEDM(Karrasetal.,2022)使用以下形式的前向过程 利用条件向量场ut(z|)提供了一个等效但易于处理的目标。 为了将损失转换为显式形式,我们将z-btψ和ψ插入到(5)中 N(t|Pm,P2其中(Kingma&Gau,2023)bt=expF )-1其中FN是正态分布的分位数函数。注意这个选择s-1 化与均值Pm和方差P结果 现在,考虑信噪比λt :=log 在BTt在乙t‑),我们可以将方程(9)重写为λ=2( 网络通过F预测进行参数化(Kingma&Gao,2023;Karras等人,2022) ,并且损失可以写为LwEDM: 接下来,我们使用方程(10)重新参数化方程(8)作为噪声预测目标: Cosine(Nichol&Dhariwal,2021)提出了以下形式的前向过程 LCFM=Et,pt(z|),p()||vθ(z,t)- 与参数化和损失相结合,这对应于权重wt=sech(λt/2)。当与v预测损失相结合时(Kingma&Gao,2023),-λt/2权重由下式给出:wt=e 我们定义θ := 请注意,当引入时间相关加权时,上述目标的最优值不会改变。因此, 缩放整流流量变压器以实现高分辨率图像合成 如图11所示,尺度参数控制采样过程中中点(正s)或端点(负s)的优先程度。该公式还包括s=0时的均匀加权πmode(t;s=0)=U(t) ,该公式已在之前的整流流工作中广泛使用(Liuetal.,2022;Maetal.,2024) )。d-1dtf模式(t) 。 并去2t ,T-1表示(LDM‑)线性LDM(Rombach等人,2022)使用DDPM时间表的修改( Ho等人,2020)。两者都是方差保留计划,即bt=1-离散时间步长t=0的细化,...。 。 。 ,扩散系数βt为at=(ts=0(1-βs)) 。12 DDPM用途 t对于给定的边界值β0和βT‑1,βt=β0+ T-1β0+t( βT-1-β0) CosMap最后,我们还考虑RF设置中第3节的余弦时间表(Nichol&Dhariwal,2021) 。 3.1.适用于RF模型的定制SNR采样器 特别是,我们正在寻找映射f :u→f(u)=t,u∈[0,1],使得log‑snr与余弦cos( πu)时间表相匹配:2logf(你) 。求解f,我们u) RF损失在[0,1]中的所有时间步上均匀地训练速度vθ 。然而,直观上,对于[0,1]中间的t,所得到的速度预测目标-x0更困难,因为对于t=0,最佳预测是p1的平均值,而对于t=1 ,最佳预测是p1的平均值。预测是p0的平均值。一般来说,将t上的分布从常用的均匀分布U(t)更改为密度为π(t)的分布相当于加权损失Lwπ 得到u�U(u) 从中我们得到密度 t 因此,我们的目标是通过更频繁地采样中间时间步来赋予它们更多的权重。接下来,我们描述用于训练模型的时间步密度π(t)。 4.文本到图像架构对于图像的文本条件采样,我们的 模型必须考虑文本和图像这两种模式。我们使用预训练的模型来导出合适的表示,然后描述我们的扩散主干的架构。图2对此进行了概述。 Logit正态采样对中间步骤给予更多重视的分布的一种选择是Logit正态分布(Atchison&Shen,1980)。它的密度, 我们的一般设置遵循LDM(Rombach等人,2022),用于在预训练自动编码器的潜在空间中训练文本到图像模型。与将图像编码为潜在表示类似,我们也遵循以前的方法(Saharia等人,2022b;Balaji等人,2022)并使用预训练的冻结文本模型对文本条件c进行编码。详细信息请参见附录B.2。 其中logit(t)=log具有位置参数m和尺度参数s。位置参数使我们能够将训练时间步长偏向数据p0(负m)或噪声p1(正m)。如图11所示,尺度参数控制分布的宽度。t1-t , 多模态扩散主干我们的架构建立在DiT(Peebles&Xie,2023)架构之上。DiT仅考虑类条件图像生成,并使用调制机制根据扩散过程的时间步长和类标签来调节网络。 在实践中,我们从正态分布u�N(u;m,s)中对随机变量u进行采样,并通过标准逻辑函数将其映射。 类似地,我们使用时间步t和cvec的嵌入作为调制机制的输入。然而,由于池化文本表示仅保留有关文本输入的粗粒度信息(Podell等人,2023),因此网络还需要来自序列表示的信息 重尾模式采样Logit‑正态密度总是在端点0和1处消失。为了研究这是否对性能产生不利影响,我们还使用了在[0,1上具有严格正密度的时间步采样分布]。对于尺度参