国产AI龙头,云边终端三位协同

AI智能总结

AI智能总结

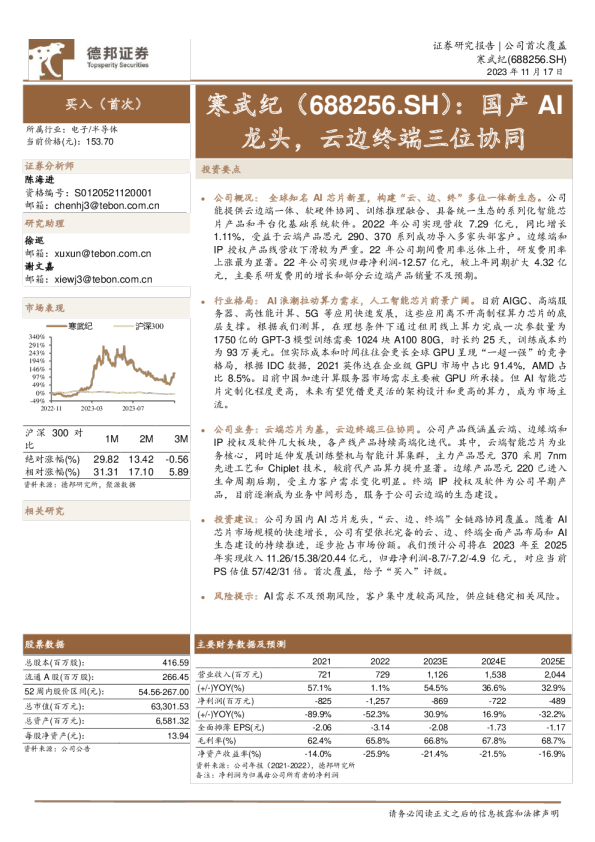

吴开达 资格编号:S0120521010001 公司概况:全球知名AI芯片新星,构建“云、边、终”多位一体新生态。公司邮箱:wukd@tebon.com.cn 能提供云边端一体、软硬件协同、训练推理融合、具备统一生态的系列化智能芯片产品和平台化基础系统软件。2022年公司实现营收7.29亿元,同比增长1.11%,受益于云端产品思元290、370系列成功导入多家头部客户。边缘端和IP授权产品线营收下滑较为严重。22年公司期间费用率总体上升,研发费用率上涨最为显著。22年公司实现归母净利润-12.57亿元,较上年同期扩大4.32亿元,主要系研发费用的增长和部分云边端产品销量不及预期。 行业格局:AI浪潮拉动算力需求,人工智能芯片前景广阔。目前AIGC、高端服务器、高性能计算、5G等应用快速发展,这些应用离不开高制程算力芯片的底层支撑。根据我们测算,在理想条件下通过租用线上算力完成一次参数量为1750亿的GPT-3模型训练需要1024块A100 80G,时长约25天,训练成本约为93万美元。但实际成本和时间往往会更长全球GPU呈现“一超一强”的竞争格局,根据IDC数据,2021英伟达在企业级GPU市场中占比91.4%,AMD占比8.5%。目前中国加速计算服务器市场需求主要被GPU所承接。但AI智能芯片定制化程度更高,未来有望凭借更灵活的架构设计和更高的算力,成为市场主流。 公司业务:云端芯片为基,云边终端三位协同。公司产品线涵盖云端、边缘端和IP授权及软件几大板块,各产线产品持续高端化迭代。其中,云端智能芯片为业务核心,同时延伸发展训练整机与智能计算集群,主力产品思元370采用 7nm 先进工艺和Chiplet技术,较前代产品算力提升显著。边缘产品思元220已进入生命周期后期,受主力客户需求变化明显。终端IP授权及软件为公司早期产品,目前逐渐成为业务中间形态,服务于公司云边端的生态建设。 投资建议:公司为国内AI芯片龙头,“云、边、终端”全链路协同覆盖。随着AI芯片市场规模的快速增长,公司有望依托完备的云、边、终端全面产品布局和AI生态建设的持续推进,逐步抢占市场份额。我们预计公司将在2023年至2025年实现收入11.26/15.38/20.44亿元,归母净利润-8.7/-7.2/-4.9亿元 , 对应当前PS估值57/42/31倍。首次覆盖,给予“买入”评级。 风险提示:AI需求不及预期风险,客户集中度较高风险,供应链稳定相关风险。 1.全球知名AI芯片新星,营收稳健增长 1.1.中国AI芯片龙头,产品矩阵扩充迅速 寒武纪是中国最具代表性的智能芯片厂商之一。中科寒武纪科技股份有限公司成立于2016年,总部位于北京,是智能芯片领域全球知名的新兴公司。2021年3月,公司上榜《EETimes》评选的“AI芯片公司(AI CHIP) TOP 10”榜单。 公司专注于人工智能芯片产品的研发与技术创新。公司的主营业务是应用于各类云服务器、边缘计算设备、终端设备中人工智能核心芯片的研发、设计和销售,为客户提供丰富的芯片产品与系统软件解决方案。自公司成立以来,产品矩阵迅速扩充,从寒武纪1A处理器开始,陆续推出了思元、玄思等芯片/加速卡/加速器产品,发展至目前形成云端产品线、边缘产品线、IP授权及软件三条产品线的产品矩阵。公司产品广泛应用于服务器厂商和产业公司,面向互联网、金融、交通、能源、电力和制造等领域的复杂AI应用场景提供充裕算力,推动人工智能赋能产业升级。 图1:公司产品矩阵迅速扩充 表1:公司三大产品线简介 1.2.实控人研发经验丰富,公司与中科院计算所关系密切 截至23年三季报,公司实控人为公司董事长、总经理陈天石,持股比例为28.69%,系公司第一大股东。陈天石博士曾在中科院计算所担任研究员(正高级职称),在人工智能及处理器芯片领域从事基础科研工作十余年,积累了坚实的理论功底及研发经验。中科院计算技术研究所独资公司北京中科算源资产管理有限公司为公司第二大股东,持股比例达15.76%。 图2:公司前五大股东股权占比 1.3.营收稳健增长,研发投入占比持续提升 公司营收稳健增长。在国内外经济形势均面临下行压力,公司坚持自主研发、提升产品成熟度、拓宽潜在市场、打造生态建设,营收实现稳健增长。2022年公司实现营业收入7.29亿元,较上年同期增长1.11%。 从营收结构来看,云端产品线收入大幅增长,边缘产品线、IP授权及软件产品线收入下滑。2022年,公司云端产品线单独对外销售部分贡献21,944.89万元的收入,占主营业务收入总额的30.37%,思元290、思元370系列加速卡和训练整机产品销量规模迅速上升,促使2022年云端产品线收入较上年同期增长173.52%。因客户进行库存调控,未按预期进度下单,2022年公司边缘产品线收入较上年同期下降78.40%。公司成功中标南京智能计算中心项目(二、三期)等项目,保持智能计算集群系统业务开展的可持续性,2022年公司智能计算集群系统业务收入较上年同期增长0.64%。2022年公司IP授权及软件产品线收入较上年同期减少83.44%,一方面由于基础系统软件平台产品主要集成在智能计算集群系统中销售;另一方面由于IP授权业务前期客户按出货量为标准进行结算的收入随客户相关产品生命周期结束而减少。 图3:公司营业收入情况 图4:公司营收结构情况 毛利率处于较高水平。2022年公司主营业务综合毛利率为65.85%,较上年增加3.46个百分点。主要原因有:(1)云端产品线思元290、思元370系列产品在多家头部企业完成产品导入,带动本期云端产品线业务收入的大幅增长;(2)毛利率相对较低的边缘端产品在报告期内的收入占比下降。 图5:公司毛利率情况 期间费用率总体上升。2022年公司销售费用率为11.35%,较上年同期增加1.44个百分点,主要是销售人员增加导致职工薪酬增加、公司积极发力智能芯片市场推广及生态建设所致;管理费用率为41%,系股份支付费用较高;财务费用率为-7.12%,主要系公司银行存款较多,银行存款利息收入较高所致。 加注研发投入,研发属性强。高质量的研发投入是芯片行业实现长远发展的坚实基础,公司大力加注研发投入,2022年研发投入总额为15.23亿元,较上年同期增加3.87亿元,同比增长34.11%。主要原因系:(1)半导体行业人才薪酬水平升高;(2)新产品流片等相关费用增加;(3)公司根据研发需求购置IP、EDA等无形资产以及研发设备等,导致无形资产摊销费用及固定资产折旧费用较上年同期增加。 图6:公司期间费用率情况 图7:公司研发投入情况 盈利端承压,亏损同比扩大。2022年公司实现归母净利润-12.57亿元,亏损金额较上年同期扩大4.32亿元,主要原因有:(1)为确保产品高质量迭代,公司持续加大研发投入,研发费用增加;(2)公司增加战略备货、处于生命周期末期的云端产品销量减少以及边缘智能芯片产品销量不及预期,导致存货及库龄增加,从而使2022年资产减值损失较上年同期有显著增加;(3)公司对个别大额应收账款进行单项计提,从而使报告期信用减值损失较上年同期有显著增加。 图8:公司归母净利润情况 2.行业格局:AI浪潮拉动算力需求,人工智能芯片前景广阔 2.1.大模型需海量算力支撑,AI服务器需求快速提升 AIGC需求兴起,产业发展依赖高制程芯片的底层算力支持。目前AIGC、高端服务器、高性能计算、5G等应用快速发展,这些应用离不开高制程算力芯片的底层支撑。以AIGC大模型为例,GPT-3的模型规模达1750亿个参数,使用单块英伟达V100GPU进行训练需要355年,对算力芯片提出了海量的需求。 而以1024块英伟达A100芯片测算,GPT-3的训练时长为25天以上。根据我们测算,在理想条件下通过租用线上算力完成一次参数量为1750亿的GPT-3模型训练需要1024块A100 80G,时长约25天,训练成本约为93万美元。但实际成本和时间往往会更长,比如模型几乎不可能一次顺利完成训练等等。 在训练算力需求之外,推理算力需求也会随着模型的商用流行度以及吸引的活跃用户数持续增加。我们认为,数量快速提升的大模型训练需求和大模型推理需求有望大幅推动以GPU为主的算力芯片市场规模提升。 图9:GPT-3训练时间及成本测算 全球AI服务器出货迅速,AI芯片市场主要为英伟达与AMD所占据。AIGC的发展带动AI服务器迅速增长,TrendForce集邦咨询预计23年AI服务器出货量约120万台,同比+38.4%,占整体服务器出货量的比约为9%,2022~2026年AI服务器出货量CAGR将达22%,而AI芯片2023年出货量将成长46%。 GPU作为数据并行处理的核心,是AI服务器的核心增量。全球GPU呈现“一超一强”的竞争格局,根据IDC数据,2021英伟达在企业级GPU市场中占比91.4%,AMD占比8.5%。 图10:2022~2026年AI服务器出货量(单位:万台) 图11:2021年企业级GPU市场份额 中国智能算力规模亦快速增长,CAGR达48%。根据IDC预测,2022年中国智能算力规模将达到268EFLOPS,预计2026年将进入每秒十万亿亿次浮点计算(ZFLOPS)级别,达到1271EFLOPS,2022-2026年CAGR48%。伴随企业AI应用成熟度逐步递增,企业将把算力更多从训练端转移到推理端负载上,这意味着AI模型将逐步进入广泛投产模式,据IDC数据,2021年中国数据中心用于推理的服务器的市场份额占比已经过半,达到57.6%,预计到2026年,用于推理的工作负载将达到62.2%。 图12:中国智能算力规模及预测 图13:中国人工智能服务器工作负载及预测 2.2.人工智能芯片定向针对AI领域,发展潜力广阔 人工智能所需的算力芯片主要分为两类,一类是以GPU、CPU为主的传统芯片,一类是专门针对人工智能领域的人工智能芯片。在人工智能数十年的发展历程中,传统芯片曾长期为其提供底层计算能力。这些传统芯片包括CPU、GPU等,它们在设计之初并非面向人工智能领域,但可通过灵活通用的指令集或可重构的硬件单元覆盖人工智能程序底层所需的基本运算操作,从功能上可以满足人工智能应用的需求,但在芯片架构、性能、能效等方面并不能适应人工智能技术与应用的快速发展。而智能芯片是专门针对人工智能领域设计的芯片,包括通用型智能芯片与专用型智能芯片两种类型。 图14:GPU与人工智能芯片对比 目前中国加速计算服务器市场需求主要被GPU所承接。根据IDC数据,2022年中国加速服务器市场规模达到67亿美元,同比增长24%,其中GPU服务器依然是主导地位,占据89%的市场份额。在AI加速应用部署的背景下,2027年中国加速服务器市场规模有望达到164亿美元,2022-2027年CAGR20%。且由于GPU仍为中国主流AI加速芯片,服务器GPU市场规模同样有望在AI的推动下持续增长。 图15:中国加速计算服务器市场规模及增速 图16:2022年中国加速服务器芯片类型市场份额占比 GPU为产业链最大增量,AI趋势下单服务器需求量大幅提升。一般的普通服务器仅会配备单卡或双卡,而AI服务器由于需要承担大量的计算,一般配置四块或以上的GPU或人工智能芯片。且AI大模型在训练与推理时的计算量巨大,中低端的处理器无法满足其运算需求。如在英伟达DGXH100中,其配备8个NVIDIA H100 GPU,总GPU显存高达640GB;每个GPU配备18个NVIDIA NVLink,GPU之间的双向带宽高达900GB/s。若以每个NVIDIA H100 GPU单价4万美元测算,DGXH100的GPU价值量为32万美元,为AI服务器中的最大增量。 图17:英伟达A100与H100算力性能情况 AI智能芯片定制化程度更高,未来有望凭借更灵活的架构设计和更高的算力,成为市场主流。相比英伟达的GPU,寒武纪人工智能芯片更类似谷歌的T