AI+专题系列点评(五):开源大模型Gemma点评

AI智能总结

AI智能总结

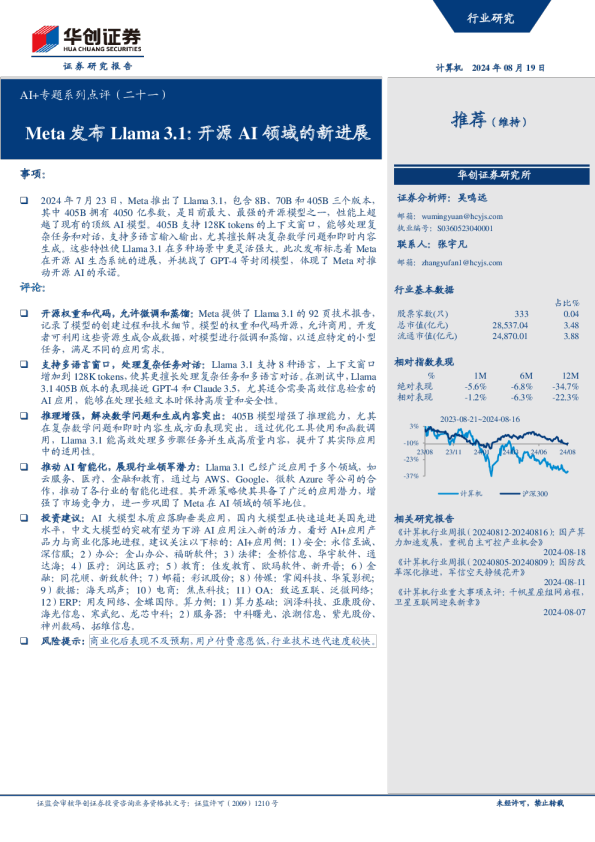

事项: 2月21日,Google推出新一代开放AI模型——Gemma。 评论: Gemma是基于改良Transformer的轻量级开放模型。Gemma与Gemini模型共享技术和基础架构,不同点在于Gemma属于开源生态系统。目前该系列发布Gemma 2B和Gemma 7B两种权重规模的模型,均有预训练和指令微调版本。Gemma 7B用于GPU和TPU高效部署和开发,Gemma 2B用于CPU和端侧应用程序。经过预训练和指令微调的Gemma模型可以在笔记本电脑、台式机或Google Cloud上运行,并可部署于Vertex AI和Google Kubernetes Engine(GKE)。 Gemma使用自研AI芯片训练,在关键基准测试集上占优。Google采用自研AI芯片TPUv5e训练Gemma模型,TPUv5e部署在由256个芯片组成的pod中,二维环形由16*16个芯片组成。Google在16个pod上训练Gemma 7B模型。在18个基于文本的任务中,有11个Gemma优于相似参数规模的开放模型。Gemma(7B)与LLaMA 2(7B)、LLaMA 2(13B)和Mistral(7B)相比,在问答、推理、数学和科学、编码等任务性能比较,除问答任务之外,Gemma(7B)均展现优势。 人类偏好评估与自动基准评估显露更优性能,拥有相当记忆量和更低记忆率。 Gemma 7B在MMLU上表现优于相同或较小规模的所有开源模型,且优于几个较大的模型,包括LLaMA2 13B。在数学任务上,Gemma模型在GSM8K和更难的MATH基准上表现超过其他模型最少10分;在HumanEval上的表现比其他开源模型至少高出6分;在MBPP上的表现超过经过代码微调的CodeLLaMA-7B模型(CodeLLaMA得分为41.4%, Gemma 7B得分为44.4%)。 在精准记忆和近似记忆的测试中,Gemma显示出较低的直接记忆率,但总记忆量与PaLM等模型持平。虽然Gemma并未被观察到存储敏感数据,但可能会记录部分潜在隐私数据。 投资建议:Gemma轻量开源,具备长文本处理能力,支持多种工具和系统,有望带动开源社区和商业世界的发展,涉及算力、大模型以及AI+应用(绘图、视频)等领域。建议关注:1)算力基础:海光信息、寒武纪、龙芯中科;2)服务器:中科曙光、浪潮信息、紫光股份、高新发展、神州数码、拓维信息等; 3)大模型:科大讯飞、商汤、三六零等;4)AI+应用:金山办公、万兴科技、美图、虹软科技、当虹科技。 风险提示:多模态技术发展不及预期、算力基础设施建设不及预期、AI应用需求不及预期。 一、轻量级开放模型,关键测试占优 Gemma是一系列轻量级开放模型。受Gemini的启发,Gemma与Gemini模型共享技术和基础架构,由Google DeepMind和Google其他团队合作开发。与Gemini不同点在于,Gemma属于开源生态系统,目前该系列发布Gemma 2B和Gemma 7B两种权重规模的模型,均有预训练和指令微调版本。其中,Gemma 7B用于GPU和TPU高效部署和开发,Gemma 2B用于CPU和端侧应用程序,不同尺寸满足不同计算限制、应用程序和开发人员要求。经过预训练和指令微调的Gemma模型可以在笔记本电脑、台式机或Google Cloud上运行,并可部署于Vertex AI和Google Kubernetes Engine(GKE)。 图表1轻量级开放模型 Gemma在关键基准测试集上占优,语言理解、推理性能强劲。Gemma支持词汇表大小达到256K,可处理超复杂长文本,对英语之外的其他语言能够更好、更快地提供支持。 在18个基于文本的任务中,Gemma在其中11个任务的表现均优于相似参数规模的开放模型,Gemma(7B)与LLaMA 2(7B)、LLaMA 2(13B)和Mistral(7B)相比,在问答、推理、数学和科学、编码等任务上的性能比较,除问答任务,Gemma(7B)均展现优势。 图表2 Gemma关键测试占优 Gemma采用改良Transformer架构,训练基础设施完善。模型训练的上下文长度为8192 tokens,Google在Transformer的基础上对多查询注意力、RoPE嵌入、GeGLU激活、Normalizer Location进行改进。Google采用自研AI芯片TPUv5e训练Gemma模型,TPUv5e部署在由256个芯片组成的pod中,二维环形由16*16个芯片组成。Google使用自研AI芯片训练模型,训练基础设施完善,在16个pod(共计4096个TPUv5e)上训练Gemma 7B,并使用2个pod对Gemma2B模型进行预训练,总计512 TPUv5e。在一个pod中,Google对7B模型使用16路模型分片和16路数据复制。对于2B模型,只需使用256路数据复制。优化器状态使用类似ZeRO-3的技术进一步分片。同时,Google使用Pathways执行数据复制还原。 图表3关键模型参数 图表4模型分类参数 Gemma采用自动技术、微调与人类反馈强化学习。Google使用自动技术,从训练集中过滤掉特定的个人信息及其他敏感数据。此外,Google进行了大量的微调和人类反馈强化学习(RLHF)。为了解并降低Gemma模型带来的风险,Google进行手工红队测试、自动对抗性测试,以及对危险活动的模型能力评估。 图表5格式化控制token 图表6对话示例 二、Gemma在人类偏好、基准评估、记忆评估表现优异 (一)人类偏好评估更胜一筹 Gemma在遵循指令和测试基本安全协议中胜率更高。与Mistral v0.2 7B Instruct相比,Gemma在创意写作任务、编码和遵循指令中Gemma 7BIT胜率为51.7%,Gemma 2B IT的胜率为41.6%。在测试基本安全协议约400条prompt中,Gemma 7B IT胜率为58%,而Gemma 2B IT胜率为56.5%。 图表7人类偏好评估更胜一筹 (二)自动基准评估优势明显 Gemma在MMLU及数学、编码基准测试中优于其他模型。在一系列学术基准上,Google将Gemma2B和7B模型与几个外部开源LLM对比,其中,Gemma 7B在MMLU上的表现优于相同或较小规模的所有开源模型,且优于几个较大的模型,包括LLaMA2 13B; 在数学任务上,Gemma模型在GSM8K和更难的MATH基准上的表现超过其他模型最少10分;在HumanEval上的表现Gemma比其他开源模型至少高出6分;在MBPP上的表现甚至超过了经过代码微调的CodeLLaMA-7B模型(CodeLLaM得分为41.4%,Gemma 7B得分为44.4%),但在人类专家评估上,Gemma仍有很大提升空间。 图表8自动基准评估更胜一筹 (三)记忆评估表现良好 较低的直接记忆率及持平的总记忆量。在对精准记忆和近似记忆的测试中,每个数据集中随机选择10,000篇文档,并使用文档开头的50个词元作为模型prompt,如果模型生成的后续50个token与文本中真实后续文本完全匹配,则将该文本分类为已记忆。测试中,Gemma显示出较低的直接记忆率,但总记忆量与PaLM等模型持平。Google使用自动方法从训练集中过滤掉某些隐私信息和其他敏感数据,并使用DLP工具依据严重性将隐私级别分为敏感、隐私。虽然Gemma并未被观察到存储敏感数据,但会记录部分潜在隐私数据(存在误报可能性)。 图表9 Gemma记忆率更低 图表10 Gemma在精准记忆和近似记忆表现良好 三、投资建议与标的 Gemma轻量开源,具备长文本处理能力,支持多种工具和系统,有望带动开源社区和商业世界的发展,涉及算力、大模型以及AI+应用(绘图、视频)等领域。 建议关注:1)算力基础:海光信息、寒武纪、龙芯中科;2)服务器:中科曙光、浪潮信息、紫光股份、高新发展、神州数码、拓维信息等;3)大模型:科大讯飞、商汤、三六零等;4)AI+应用:金山办公、万兴科技、美图、虹软科技、当虹科技。 四、风险提示 多模态技术发展不及预期、算力基础设施建设不及预期、AI应用需求不及预期。